Table of Contents

La inferencia en IA -el momento en que un modelo entrenado procesa datos nuevos para hacer predicciones o tomar decisiones- se ha convertido en uno de los mayores desafíos técnicos y económicos para las empresas.

En este contexto, Red Hat, al inaugurar su Red Hat Summit 2025, realizó varios anuncios clave, entre ellos su compromiso por maximizar el rendimiento de las soluciones de IA mediante eficiencia, escalabilidad y una visión orientada al futuro.

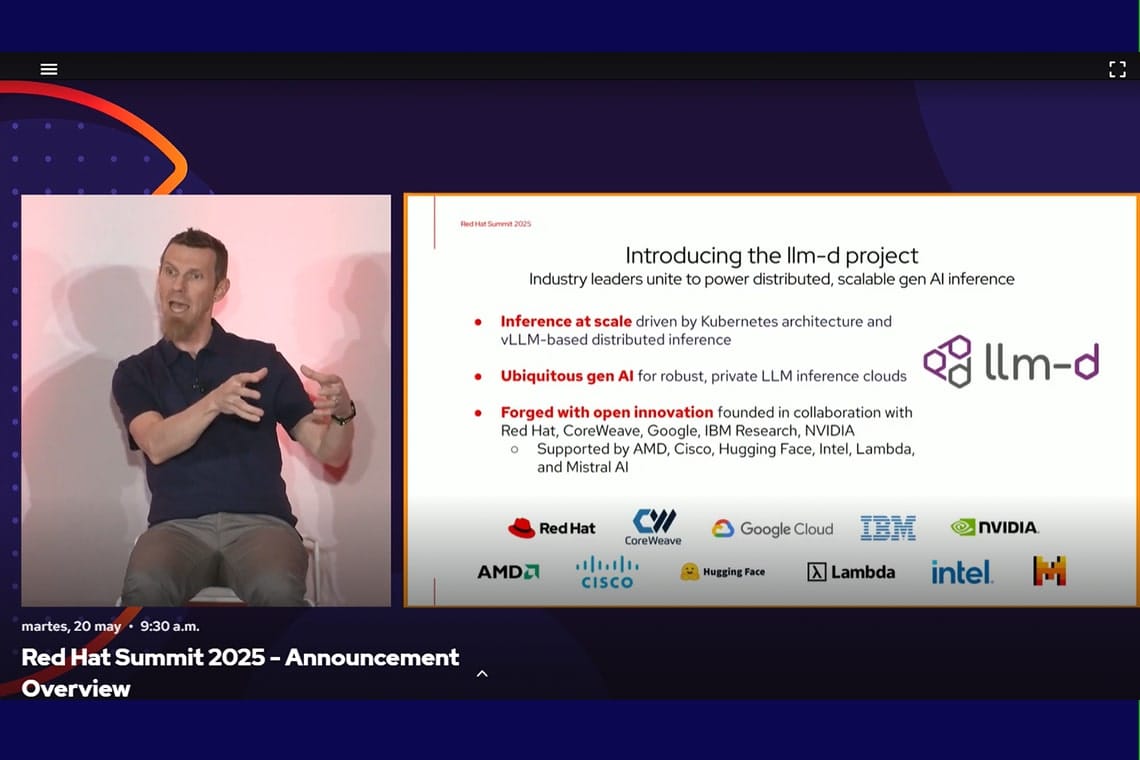

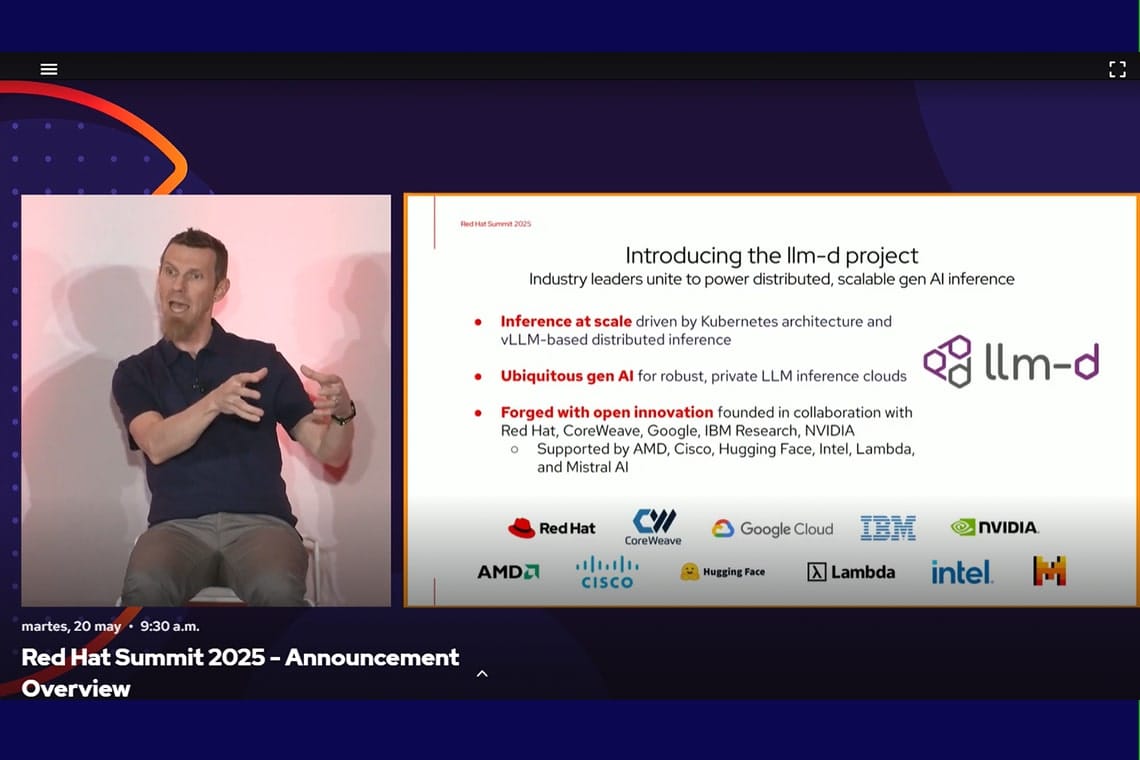

LLM-D: orquestación inteligente para modelos LLM

Uno de los temas más destacados fue LLM-D (Large Language Model Daemon), un proyecto open source diseñado para distribuir de forma inteligente la inferencia de modelos de lenguaje (LLM).

Construido sobre Kubernetes, LLM-D permite escalar el uso de GPUs -que en muchos casos apenas alcanzan un 20 % de utilización- hasta niveles cercanos al 100 %, lo que reduce los costos por token y acelera la respuesta de los modelos en producción.

Con esta apuesta, Red Hat impulsa un enfoque que optimiza recursos y lleva la IA generativa a entornos empresariales reales, aprovechando tecnologías como VLLM para lograr una inferencia más rápida y sostenible.

Inferencia en IA (Inference Time Scaling)

Chris Wright, CTO de Red Hat (en la foto), presentó el concepto de Inference Time Scaling, una técnica que mejora los resultados de los modelos al permitirles «pensar» durante más tiempo antes de generar una respuesta.

Este método requiere un balance cuidadoso entre el uso de memoria y procesamiento para mantener la eficiencia sin sacrificar la calidad.

Llama Stack y el auge de los agentes inteligentes

Red Hat también presentó avances en el desarrollo de agentes de IA: asistentes capaces de razonar, actuar y automatizar tareas complejas utilizando datos empresariales.

Para ello, presentó Llama Stack, un conjunto de APIs que permite a los desarrolladores crear agentes utilizando modelos como Llama de Meta, facilitando su integración con herramientas, flujos de trabajo y sistemas existentes.

Este enfoque representa la transición de los simples chatbots hacia asistentes inteligentes con verdadero impacto en la productividad.

Seguridad, colaboración y ecosistema abierto

La compañía reiteró su compromiso con la seguridad y el código abierto, destacando alianzas estratégicas con Google, CoreWeave, IBM Research, NVIDIA, Meta y Hugging Face.

Red Hat reafirmó que la colaboración comunitaria continúa siendo el camino más adecuado para acelerar la adopción empresarial de la inteligencia artificial.

Red Hat Enterprise Linux 10: base sólida para la nube híbrida

Finalmente, Red Hat presentó Red Hat Enterprise Linux 10, una plataforma preparada para liderar los entornos de nube híbrida, con IA integrada, seguridad poscuántica y compatibilidad con arquitecturas emergentes como RISC-V.

Esta nueva versión permite gestionar entornos mediante imágenes de sistema e integra herramientas como Red Hat Insights, diseñadas para optimizar la toma de decisiones antes de pasar a producción.

Red Hat Enterprise Linux 10 ya está disponible para clientes y desarrolladores, marcando un nuevo capítulo en la estrategia empresarial de la compañía hacia una IA escalable, abierta y segura.

En la foto principal de izquierda a derecha: Stephanie Wonderlick, Vice President, Brand Experience + Communications; Matt Hicks, CEO de Red Hat; Chris Wright, CTO de Red Hat y Ashesh Badani, Líder de producto de Red Hat.